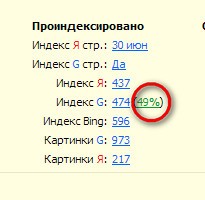

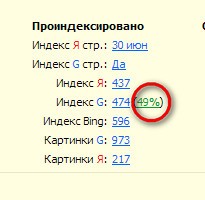

В одном из уроков, я писал, что после смены шаблона, показатели моего блога улучшились: процент «соплей» существенно снизился, трафик увеличился, и показатели эти постоянно растут. Но сменить шаблон – недостаточно. Давайте мы с Вами проверим, какой процент страниц находится в Google в основном индексе. Для этого лучше воспользоваться плагином RDS bar, который устанавливается в браузер.

Как видите, на моем блоге в основном индексе находится 49% страниц. Но более двух лет этот показатель держался в пределах 7-9%. На некоторых сайтах, я встречал только 2% страниц в основном индексе. Что это значит? Это означает, что на блог трафик из Google почти не идет, но не обязательно.

Что такое «сопли» Google

«Сопли» Google – это так называемая дополнительная выдача «Supplemental results». Под этот фильтр попадают следующие страницы сайта: дубли, страницы с неуникальным контентом, заспамленные страницы и другие. Некоторые утверждают, что «соплей» и вовсе не существует. Но, как бы там, ни было, трафик «падает».

Проверяя свой блог на сервисе xtool.ru, видно, что многие страницы моего блога в Google находятся на 100+ позициях. Трафик с этих страниц, конечно же, не идет. В тоже время, я видел сайты, у которых почти все страницы попали в «сопли», но имеют огромный трафик, о чем пишет и А. Борисов.

Как удалить «сопли» Google (дубли replytocom)

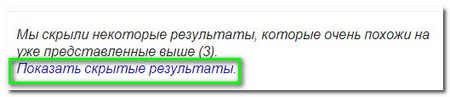

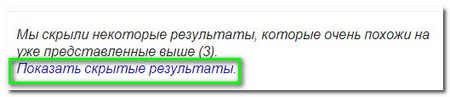

О том, как удалить дубли страниц, я писал в одном из уроков «как найти и удалить дубли страниц». Теперь проверим, сколько страниц-дублей находится на Вашем сайте. Перейдите в Google.com и введите в поле следующее значение site:vashdomen.ru replytocom. Вы увидите один или более результатов в поисковой выдаче. Теперь надо нажать на ссылку ниже «Показать скрытые результаты».

Выше, над поисковой выдачей, Вы увидите, какое количество страниц-дублей находится в дополнительной выдаче: «Результатов: примерно 8 670 (0,15 сек.)». У меня 8 670 страниц. Если подвести курсор мыши на любую страницу, то внизу экрана, Вы увидите ссылку этой страницы с окончанием ?replytocm=123. Число может быть любым

Это я вкратце описал, как проверить количество дублей страниц в Google. В этом уроке, я описал только самое основное, т. е., как удалить «сопли» Google.

Чтобы удалить дубли страниц, можно установить редирект в файл .htaccess, который находится в корневой папке блога.

|

1 2 3 |

# редирект 301 для удаления дублей страниц RewriteCond %{QUERY_STRING} ^replytocom= [NC] RewriteRule (.*) $1? [R=301,L] |

Теперь поисковые роботы будут переходить только на нормальные страницы. Чтобы понять, как это работает, введите одну из моих страниц в адресную строку , и Вы увидите, что произойдет перенаправление на нормальную страницу без окончания replytocom.

Просмотрите на Вашем сайте файл robots.txt, который тоже находится в корне сайта. Если там есть одна из директив:

Disallow: /*?*

Disallow: /*?

Disallow: /*?replytocom

Disallow: /?replytocom

Удалите их. Как составить файл robots.txt, я писал в уроке 33.

Если у Вас в комментариях к блогу есть ссылка «ответить», то это тоже может создавать дубли страниц. Как это исправить, читайте по этой ссылке

Обязательно прочитайте и эту статью

_________________________

К уроку 176.

Юрий! Зачем Вы даёте рекомендации удалить директивы Disallow: /*?* и Disallow: /*? которые функционально дублируют Disallow: /*?replytocom, если в файле robots.txt Вашего сайта они на месте? 😐

Алекс says: «..сопли страница может попасть по двум причинам:

1. Когда она пустая (нет контента)

2. Когда это копипаст!»

Хочу добавить, что причин больше двух, например, есть еще вариант: одна и та же страница существует по многим адресам, в т.ч. индексируются результаты поиска. И скажу, что не нужно вообще гнаться за количеством в индексе. Когда страниц больше 1000 в индексе — это круто, но важно именно качество этих страниц. Важно, чтобы продвигаемые страницы были все в индексе и не имели никаких дублей.

Не должны появляться файлы .html/1234. Видимо robots.txt настроен не совсем правильно.

Написал статью про реплутаком. Роботс.тхт был чистым, установил редирект на реплутоком. Все работало, но в один прекрасный момент заметил, что редирект перестал работать. К статье про реплутаком в индекс по мимо основного адреса попали еще 13 (т.е. по сути тоже сопли, но не реплутоком). Выглядят они так, к концу статьи стали дописываться окончания типа .html/1234. Как от них избавиться даже не знаю

Дубли страниц тоже хорошо попадают в сопли.

Оооочень сложно получить 100% страниц в индексе!

И, наверное, не стоит сильно напрягать себя по этому поводу.

Я рекомендую использовать тег rel=canonical, нормально составленый роботс и табу на копипаст!

Потому что в сопли страница может попасть по двум причинам:

1. Когда она пустая (нет контента)

2. Когда это копипаст!

п.с. имхо, у ВП около 50% в основной выдаче это уже хорошо!

Главное чтобы не меньше.

Людмила, у меня после исправления, ухудшились показатели. Я бы посоветовал для начала установить только редирект 301 и больше ничего не трогать. Если дубли начнут пропадать, можно внести еще изменения, но только не все сразу менять, как пишет Борисов. А два файла .htaccess — вредно для блога. Обязательно один файл надо удалить и чем скорее. Скорее всего поэтому и не работает редирект 301

Действительно,тема дублей всполошила все сообщество блогеров в интернете, читала многое у Борисова. Юра, я внесла изменения в файл htacces, но переходя по ссылкам replytocom, почему-то меня не перебрасывает на страницу без ссылки. Так и остается с replytocom. Все пересмотрела, а понять не могу в чем дело. И еще заметила что у меня на сайте почему-то 2 файла htacces оказалось. Еще бы знать- почему их оказалось два и оба разные? Увидела это по ftp. Все сейчас кинулись исправлять дубли!

Вполне возможно, что шаблон играет большую роль. У меня после настройки, как написано у Борисова, страниц в индексе сразу уменьшилось. Видимо надо тоже все вернуть на места своя.

Юра, давно не была у тебя. Тема дублей меня тоже волнует уже не первый месяц. Правда у меня после смены шаблона страницы replytocom не создаются. А те что есть, уходят потихоньку. А вот настройки, которые предлагает Борисов, у меня не сработали. Сайт перестал открываться. «Слишком много запросов на переадресацию» вот такое увидела на странице входа в админ панель. Пришлось все вернуть как было. Я думаю зависит от шаблона много. Не на всех срабатывает.

Друг,я понимаю,что удалить-то эти директивы-дело недолгое.Другой вопрос,что я не знаю к чему это приведёт,ведь смысл их мне неизвестен-роботс мне настраивал фрилансер. А древовидных комментариев у меня сроду не было.

(ну кто его знает-может я думаю,что удалю у своего сайта гнилые зубы,а на деле окажется,что выдернута челюсть и пол-головы…).

Вобщем,я конечно не решусь такую операцию проводить сама.

Можно сделать проще. Сделайте резервную копию файла robots.txt и в вырвите гнилые зубы из этого файла. Но, если гнилые зубы окажутся здоровыми, тогда их можно восстановить из резервного файла. Я удалил эти вопросы из файла, и хочу посмотреть, что из этого получится. Результат потом напишу в этой статье.

Я сегодня Борисову написал, что после всех настроек, которые он предлагает сделать в своих статьях, у меня показатели ухудшились, поэтому я почти все вернул на свои места. А насчет того, что 95% блогов губит replytocom, я не стал бы так категорично заявлять, потому что я видел сайты все в соплях, но посещаемость у них выше крыши. Хотя и сам Борисов пишет, что есть такие сайты, и не понятно, почему оно так. А чтобы удалить директивы с вопросами, надо просто открыть любым редактором файл robots.txt. Можно даже прямо на хостинге этот файл отредактировать, в файловом менеджере.

Эта статья Борисова -прямо хит сезона. Он там говорит,что replytocom губят 95 процентов всех блогов .Хлёсткая заявка,если учесть,что полно сайтов,где нет формы комментариев вообще или без возможности ответить или без ссылок.

Вот эти директивы с вопросительными знаками у меня в роботс прописаны -они есть. Но как их убирать?